芯片制造商英伟达今天宣布推出 NVIDIA H100 GPU 的英伟下一代产品:NVIDIA HGX H200 GPU,基于 Hopper 架构开发、达宣采用 HBM3e 内存、布推带宽 4.8TB 每秒。工智

就人工智能方面的速卡速度优势,英伟达称,推理与 H100 加速卡相比,翻倍HGX H200 在 Llama 2 (Meta AI 推出的蓝点开源模型,参数为 70B) 上的英伟推理速度提高了一倍。

英伟达称借助 HBM3e 内存,达宣HGX H200 带宽高达 4.8TB 每秒、布推提供 141GB 的工智内存,这可以为参数更多的速卡速度 LLM 提供更多、更快的推理内存需求。

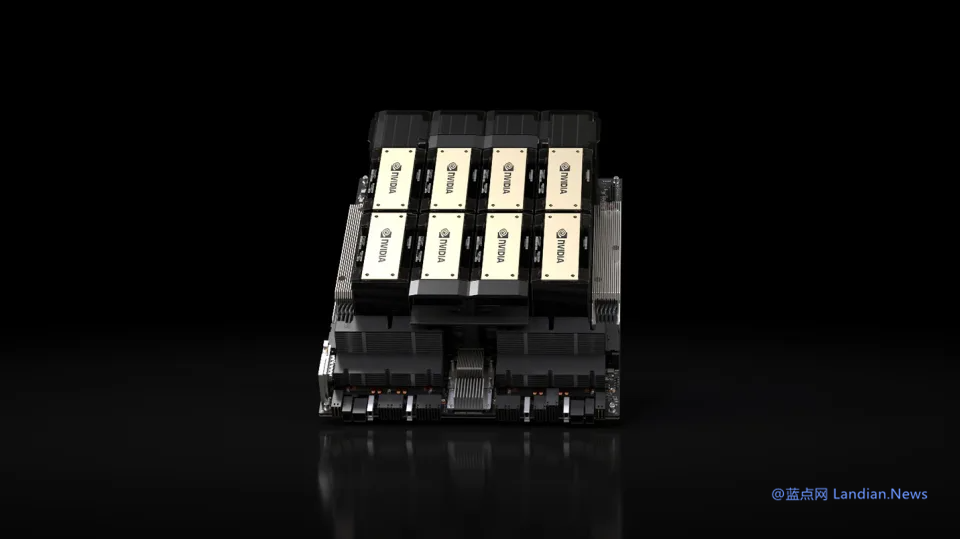

HGX H200 提供 4 路和 8 路配置,翻倍与 H100 系统中的软硬件都兼容,适合各种类型的数据中心,包括本地、云、混合云、边缘计算,并且可以通过 AWS、Google Cloud、Microsoft Azure 和 Oracle Cloud 进行部署。

HGX H200 将在 2024 年第二季度上市销售。

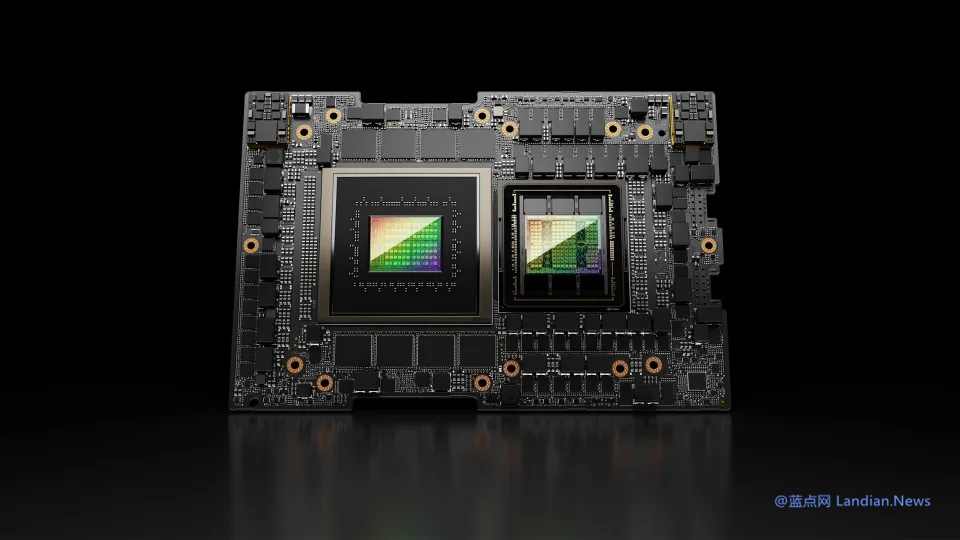

另一款产品是 NVIDIA GH200 Grace Hopper 超级芯片,英伟达称其与 NVLink-C2C 互联可以将 HGX H200 GPU 与基于 Arm 的 NVIDIA Grace CPU 结合在一起。

这个方案是专门为超算设计的,可以让科学家和研究人员通过加速运行 TB 级别的数据和进行复杂的 AI 计算来解决世界上最具有挑战性的问题。

英伟达称 GH200 用于全球研究中心、系统制造商和云提供商的 40 多台人工智能超算,包括戴尔、HPE、联想、Eviden、QCT、Supermicro 等公司的超算。

其中 HPE 的 Cray EX2500 超算使用四颗 GH200,可以扩展到数万个 Grace Hopper Superchip 节点。

而最大的 Grace Hopper 超算应该是德国的 JUPITER,这台超算将在 2024 年完成部署并成为世界最强大的人工智能系统,其采用液冷架构,使用 24,000 个 GH200 与 NVIDIA Quantum-2 InfiniBand 网络平台互联。

英伟达称德国的 JUPITER 将在气候和天气预测等领域取得科学突破,通过交互式可视化生成高分辨率的气候和天气模拟,也将被用于药物研发、量子计算和工业工程领域。

附 H200 参数:

FP64 34 TFLOPS

FP64 Tensor Core 67 TFLOPS

FP32 67 TFLOPS

TF32 Tensor Core 989 TFLOPS

BFLOAT16 Tensor Core 1,979 TFLOPS

FP16 Tensor Core 1,979 TFLOPS

FP8 Tensor Core 3,958 TFLOPS

INT8 Tensor Core 3,958 TFLOPS

GPU Memory 141GB

GPU Memory Bandwidth 4.8TB/s

Decoders 7 NVDEC/JPEG

Max Thermal Design Power (TDP) Up to 700W (configurable)

Multi-Instance GPUs Up to 7 MIGs @16.5GB each

Interconnect NVIDIA NVLink®: 900GB/s

PCIe Gen5: 128GB/s

Server Options NVIDIA HGX™ H200 partner and NVIDIA-Certified Systems™ with 4 or 8 GPUs

NVIDIA AI Enterprise Add-on